Général

Le plus grand laboratoire d’imagerie médicale d’Australie forme une IA avec ses données d’examen : les patients sont dans l’ignorance !

Une révélation choquante : la plus grande entreprise de radiologie d’Australie a transmis, sans le savoir des patients, des scans médicaux privés à une start-up, Harrison.ai, pour entraîner une intelligence artificielle. Ce transfert de données soulève des questions éthiques et juridiques, car les patients n’ont pas été informés. Les experts en confidentialité s’inquiètent de cette pratique, qui pourrait violer les lois australiennes sur la protection des données. La transparence est essentielle, et les patients devraient avoir leur mot à dire sur l’utilisation de leurs informations sensibles.

Scandale de la Confidentialité : Des Données Médicales Utilisées pour Former l’IA

La plus grande entreprise de radiologie d’Australie a transmis les scans médicaux privés de potentiellement des centaines de milliers de patients, sans leur consentement, à une start-up qui les utilisera pour entraîner des intelligences artificielles. Des experts en protection de la vie privée affirment qu’il s’agit d’une pratique qui devrait être protégée par la loi.

Une Start-up Prometteuse

Harrison.ai, une entreprise technologique australienne, se présente comme une société valant plus de 200 millions de dollars, soutenue par des noms prestigieux du secteur des start-ups et de la santé en Australie, tels que Blackbird Ventures et Skip Capital, fondée par Scott Farquhar d’Atlassian. Le conseil d’administration inclut Robyn Denholm, présidente de Tesla, et le gouvernement fédéral ainsi que l’opposition ont salué cette entreprise.

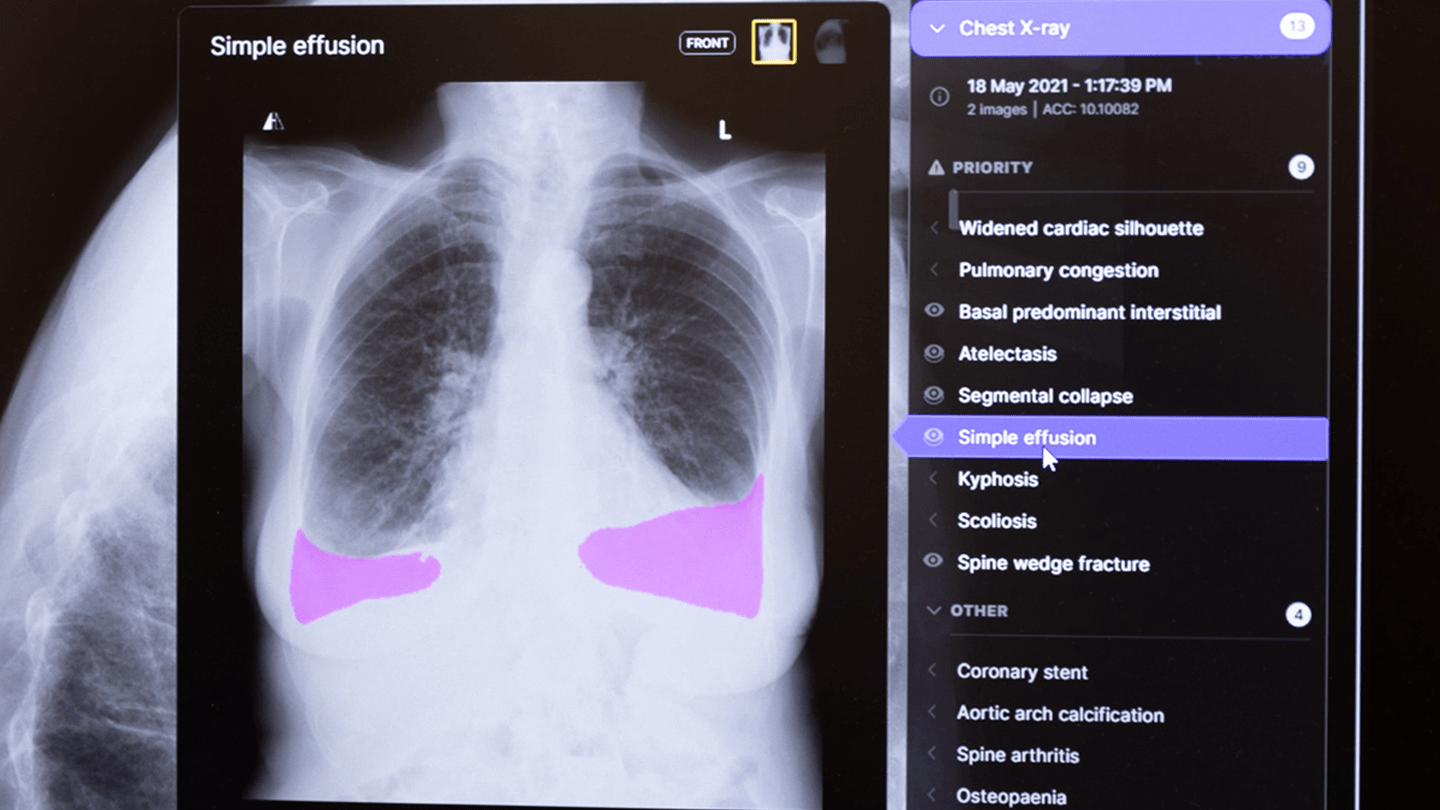

Le produit phare de Harrison.ai est un outil capable d’analyser des radiographies thoraciques pour aider les cliniciens à détecter des anomalies telles que des poumons effondrés ou des stents. Selon l’entreprise, cet outil, ainsi qu’un autre pour les scans cérébraux, est désormais accessible à un radiologue sur trois en Australie, ainsi que dans des cliniques en Europe, au Royaume-Uni, en Asie-Pacifique et aux États-Unis.

Une Base de Données Controversée

Ce qui reste flou, c’est la manière dont cette immense quantité de données médicales sensibles a été légalement utilisée ou divulguée par I-MED et Harrison.ai. Les scans ont été formés à partir d’un modèle d’IA qui a été entraîné sur 800 000 radiographies thoraciques provenant d’un ensemble de données jugé « considérable et précieux » de I-MED Radiology Network, le plus grand fournisseur d’imagerie médicale d’Australie, ainsi que d’autres sources.

Si la société de radiologie a demandé le consentement de ses patients pour utiliser leurs scans à des fins commerciales, il ne semble pas y avoir de preuves publiques à cet égard, et les patients ne semblent pas en être informés. Même si un consentement avait été obtenu, la gestion des données par les entreprises pourrait ne pas être conforme à la législation australienne sur la vie privée. Les experts estiment qu’il est raisonnable de s’attendre à ce que les Australiens soient consultés avant que leurs informations de santé sensibles ne soient utilisées pour former une IA à des fins lucratives.

Une Évolution Nécessaire

Dr Bruce Baer Arnold, expert en protection de la vie privée, souligne que les médecins, en particulier les spécialistes, ont traditionnellement considéré ces données comme leur propriété. « À l’ère de l’IA, il est plus approprié de considérer que vous êtes le gardien des données », déclare-t-il.

Malgré plusieurs tentatives de contact par email, message texte, téléphone et LinkedIn, ni Harrison.ai ni I-MED n’ont répondu.

Une Histoire de Succès

Fondée en 2018 par Dr Aengus Tran et son frère Dimitry, Harrison.ai a d’abord développé un modèle d’IA pour aider à la sélection d’embryons pour la FIV. En lançant des produits pour les radiographies thoraciques et les biopsies de prostate, l’entreprise a rapidement gagné en popularité dans le milieu des start-ups australiennes. En 2021, elle a levé 129 millions de dollars et cherche actuellement à obtenir des financements supplémentaires.

Le partenariat avec I-MED, qui possède 250 cliniques de radiologie en Australie, a été un élément clé de son succès. En 2019, I-MED a annoncé la création d’une coentreprise avec Harrison.ai, nommée Annalise.ai, pour « développer des moteurs de prédiction de classe mondiale pour des modalités d’imagerie clés ». Bien qu’Annalise.ai ait été intégrée à Harrison.ai, elle reste le nom de sa gamme de produits.

Des Résultats Impressionnants

Un article de recherche publié en 2021 dans la revue médicale prestigieuse The Lancet a présenté le premier outil d’Annalise.ai pour analyser les radiographies thoraciques, Annalise CXR. L’étude a révélé que les radiologues utilisant cette technologie étaient tout aussi efficaces, voire meilleurs, pour détecter 124 « découvertes » médicales que les radiologues non assistés.

Cette avancée a été saluée comme une « révolution » dans le soutien aux radiologues. L’outil a depuis été approuvé dans plus de 40 pays et déployé dans des régions comme le Royaume-Uni, les États-Unis, la Malaisie et Hong Kong. Récemment, Ed Husic, ministre de l’Industrie et de la Science d’Australie, a cité Harrison.ai comme un exemple d’IA qui « ne pose pas nécessairement de risque » lors du lancement des nouvelles régulations sur l’IA dans le pays.

La Question du Consentement Éclairé

Les données de santé sont parmi les informations personnelles les plus sensibles. Les règles concernant leur collecte, leur utilisation et leur divulgation en Australie sont complexes, mais en général, les patients doivent donner un consentement explicite pour leur utilisation ou avoir une attente raisonnable quant à leur utilisation (comme en cas d’urgence vitale).

Dans le cas d’I-MED, il est incertain comment l’entreprise a cherché à obtenir le consentement pour utiliser les données de ses patients à cette fin. Les conditions de service de l’entreprise stipulent qu’elle gère les informations personnelles conformément à sa déclaration de confidentialité, qui ne mentionne pas que les données seront utilisées pour former des IA ou partagées avec d’autres entités à cette fin. Bien qu’il soit indiqué que l’entreprise pourrait partager des données avec « des organismes de recherche autorisés par la loi australienne », cela ne semble pas correspondre à la classification d’une entreprise qui commercialise ces données, même si elle a mené des recherches.

ole Archer a effectué une radiographie thoracique chez I-MED au milieu des années 2010 et ne se souvient pas avoir donné son accord pour que ses données soient utilisées pour former une intelligence artificielle. Elle a exprimé à Crikey sa déception d’apprendre que cela s’était probablement produit sans son consentement.

« J’ai appris à m’attendre à ce que les grandes entreprises ne prennent pas en compte mes intérêts, mais il est déconcertant de découvrir qu’elles utilisent vos données (et quelque chose d’aussi personnel) de cette manière », a-t-elle déclaré.

Nicole a mentionné qu’elle aurait probablement accepté que ses données soient utilisées de cette façon si elle avait été informée, compte tenu des bénéfices potentiels et des expériences de sa famille avec le cancer. Maintenant qu’elle est au courant, Nicole se montre moins confiante envers les entreprises et envisage de reconsidérer son utilisation d’I-MED à l’avenir.

Elle a, avec plusieurs experts interrogés par Crikey, comparé cette situation à celle d’Henrietta Lacks, une femme afro-américaine dont les cellules ont été prélevées sans consentement après une intervention médicale en 1951. Ses cellules, connues sous le nom de cellules « HeLa », ont montré la capacité de se reproduire indéfiniment en laboratoire, devenant ainsi un outil précieux pour les chercheurs et posant les bases d’une grande partie de la médecine moderne et de sa commercialisation. L’utilisation de ces cellules et la publication de leur séquence ADN en 2013 ont suscité une controverse significative concernant les droits des patients et l’utilisation des données médicales.

Le Dr Arnold a déclaré que l’utilisation des données des patients pour former une IA sans leur connaissance était « éthiquement discutable », même si des bases légales solides existaient.

« Je suis allé faire une prise de sang aujourd’hui. Je serais plutôt mécontent de découvrir que, par exemple, la société de pathologie partage ce qu’elle prétend être des données anonymisées, dé-identifiées, etc., à des partenaires non identifiés », a-t-il ajouté.

Arnold a précisé que l’anonymisation des données contribue à protéger la vie privée des personnes dont les scans ont été partagés, tout en dissuadant les actions réglementaires, mais cela ne donne pas aux entreprises le droit d’utiliser et de divulguer des données sans consentement.

« La manière dont les entreprises contournent généralement cela est de dire ‘nous nous réservons le droit de partager avec nos partenaires’ sans préciser qui… mais d’un point de vue de recherche en sciences de la vie, vous voudriez respecter les meilleures pratiques », a-t-il expliqué.

L’anonymisation d’un scan ne signifie pas qu’un individu ne peut pas être identifié à partir de celui-ci. Un article de The Lancet indique que les données d’entraînement ont subi un « processus d’automatisation de dé-identification ».

Le Dr Vanessa Teague, cryptographe à l’ANU, a prouvé que les données anonymisées de Medicare et des transports publics de Victoria peuvent être utilisées pour identifier des individus. Elle suggère que des radiographies thoraciques, associées à des détails comme l’âge et le sexe, pourraient suffire à réduire l’identification à un petit groupe de personnes.

« En fin de compte, il est clair que ce sont des données identifiables, au moins pour certaines personnes et possiblement pour beaucoup d’autres », a-t-elle déclaré.

Teague souligne que la légalité de la divulgation de ce type de données est ambiguë. « Est-il illégal de les transmettre ? Cela peut ne pas l’être, mais cela devrait l’être. »

Questions en suspens

De nombreux détails concernant l’accord entre Harrison.ai et I-MED restent flous.

L’article publié dans The Lancet ne précise pas qui a anonymisé le jeu de données, soulevant des questions sur la quantité d’informations transmises par I-MED et le moment de l’anonymisation.

L’outil Annalise.ai de Harrison.ai pour les scans CT de la tête a été formé sur plus de 200 000 scans provenant d’un « groupe de radiologie privé en Australie », selon un document de 2023. Ce document ne précise pas quel groupe de radiologie, bien qu’il signale dans sa section de conflit d’intérêts que deux de ses auteurs sont employés par I-MED.

Harrison.ai a demandé et obtenu l’approbation éthique pour son article dans The Lancet de l’Université Notre-Dame d’Australie en 2020. La demande et la décision n’ont pas été publiées, ce qui est normal, et un responsable du comité d’éthique de Notre-Dame a renvoyé les demandes d’accès aux documents à l’équipe médiatique, qui n’a jamais répondu.

Il n’est pas clair si I-MED a d’autres arrangements similaires avec d’autres entreprises technologiques ou d’autres sociétés pour divulguer des données patients. Harrison.ai a un partenariat avec Sonic Healthcare, coté à l’ASX, appelé Franklin.ai, qui a développé un outil pour analyser des échantillons de biopsie de prostate.

Harrison.ai et I-MED n’ont pas répondu aux demandes répétées par divers canaux, y compris via le formulaire de contact en ligne de Harrison.ai, deux agences de relations publiques représentant Harrison.ai, la ligne d’assistance nationale d’I-MED, et l’email du responsable des communications nationales d’I-MED.

Un responsable des communications d’I-MED contacté via LinkedIn a dirigé Crikey vers le responsable des communications nationales de l’entreprise, mais une fois que j’ai mentionné que j’avais tenté de les contacter à plusieurs reprises, il n’a pas répondu.

Un représentant de Blackbird Ventures a informé Crikey qu’il signalerait notre demande au personnel de Harrison.ai et espérait que nous aurions des nouvelles avant notre délai.

Ces questions surviennent à un moment délicat pour Harrison.ai et I-MED. Harrison.ai effectue une campagne de presse pour le lancement de son nouveau modèle d’IA et pour promouvoir sa levée de fonds de série C, qui devrait rapporter « plus de 100 millions de dollars ». Pendant ce temps, les propriétaires d’I-MED, en capital-investissement, cherchent à vendre l’entreprise pour un montant pouvant atteindre 3 milliards de dollars, un prix colossal soutenu en partie par ses « plus de 10 millions d’images » et sa participation dans cette entreprise d’IA.

Les données des patients sont clairement d’une valeur inestimable, tant pour la recherche que pour l’avantage commercial d’une entreprise. Mais cela ne signifie pas que les entreprises devraient les utiliser sans demander l’accord de leurs patients, a souligné Arnold.

« Si cela peut sauver des vies ou réduire les coûts. J’adore ça, donnez-moi ce choix et je le signerai. Je préfère cela à ce paternalisme – j’ai fait le scan, c’est mes données, je peux en faire ce que je veux. Oh, et au fait, je vais gagner beaucoup d’argent. »

Général

Anker SOLIX dévoile la Solarbank 2 AC : la nouvelle ère du stockage d’énergie ultra-compatible !

Découvrez le Solarbank 2 AC, une véritable révolution dans le domaine de l’énergie solaire ! Grâce à ses batteries au phosphate de fer lithium, ce système s’adapte parfaitement à vos besoins. Avec une puissance impressionnante de 2400 watts et la possibilité d’ajouter jusqu’à cinq batteries supplémentaires, il assure un stockage optimal. Sa compatibilité avec le compteur Anker SOLIX Smart favorise une gestion intelligente de votre consommation énergétique. Ne ratez pas l’offre spéciale « early bird », disponible dès maintenant pour seulement 999 euros ! Saisissez cette chance unique !

Le Solarbank 2 AC : Une Révolution dans le Stockage Énergétique

Batteries au Lithium Fer Phosphate

Le Solarbank 2 AC se démarque par l’utilisation de batteries au lithium fer phosphate (LFP), reconnues pour leur sécurité et leur efficacité. Ce modèle est particulièrement innovant grâce à son système de couplage alternatif, qui lui permet de s’adapter facilement à divers systèmes solaires déjà en place.Que ce soit pour des installations sur toiture, des systèmes solaires compacts pour balcons ou d’autres configurations réduites, il peut fonctionner avec un micro-onduleur de 800 Watts.

Capacité et flexibilité Énergétique

Avec une capacité maximale d’injection dans le réseau domestique atteignant 1200 watts,le Solarbank 2 AC peut être associé à deux régulateurs solaires MPPT. Cela ouvre la possibilité d’ajouter jusqu’à 1200 watts supplémentaires via des panneaux solaires additionnels, portant ainsi la puissance totale à un impressionnant 2400 watts. Pour les utilisateurs nécessitant davantage de stockage énergétique, il est possible d’intégrer jusqu’à cinq batteries supplémentaires de 1,6 kilowattheure chacune, augmentant la capacité totale à 9,6 kilowattheures.

Intégration dans un Écosystème Intelligent

Le Solarbank 2 AC s’intègre parfaitement dans un écosystème énergétique intelligent grâce à sa compatibilité avec le compteur Anker SOLIX Smart et les prises intelligentes proposées par Anker. cette fonctionnalité permet une gestion optimisée de la consommation électrique tout en réduisant les pertes énergétiques inutiles. De plus, Anker SOLIX prévoit d’étendre cette compatibilité aux dispositifs Shelly.

Durabilité et Résistance aux Intempéries

Anker SOLIX met également l’accent sur la longévité du Solarbank 2 AC. Conçu pour supporter au moins 6000 cycles de charge, cet appareil a une durée de vie estimée dépassant quinze ans. Il est accompagné d’une garantie fabricant décennale et possède une certification IP65 qui assure sa résistance face aux intempéries tout en étant capable de fonctionner dans des températures variant entre -20 °C et +55 °C.

Disponibilité et Offres Promotionnelles

Le solarbank 2 AC est disponible sur le site officiel d’Anker SOLIX ainsi que sur Amazon au prix standard de 1299 euros. Cependant, une offre promotionnelle « early bird » sera active du 20 janvier au 23 février 2025, permettant aux acheteurs intéressés d’acquérir cet appareil dès 999 euros ! Cette promotion inclut également un compteur Anker SOLIX Smart offert pour chaque commande passée durant cette période spéciale.

le Solarbank 2 AC représente une avancée significative dans le domaine du stockage énergétique domestique grâce à ses caractéristiques techniques avancées et son engagement envers la durabilité environnementale.

Business

Une formidable nouvelle pour les conducteurs de voitures électriques !

Excellente nouvelle pour les conducteurs de véhicules électriques ! La recharge gratuite sur le lieu de travail sera exonérée d’impôts jusqu’en 2025. Annoncée par le ministère de l’Économie, cette mesure incitative, en place depuis 2020, s’inscrit dans une dynamique de croissance impressionnante avec une progression annuelle moyenne de 35%. Les entreprises peuvent ainsi offrir des bornes de recharge sans impact fiscal, stimulant la transition écologique. Reste à savoir si cela suffira à convaincre les entreprises hésitantes et à propulser l’électrification des flottes professionnelles vers un avenir durable.

Technologie

Recharge Électrique au Bureau : Une Exonération Fiscale Renouvelée

Les détenteurs de véhicules électriques et leurs employeurs peuvent se réjouir : la possibilité d’effectuer des recharges gratuites sur le lieu de travail sera exonérée d’impôts jusqu’en 2025. Cette décision, annoncée par le ministère des Finances, prolonge une initiative lancée en 2020 pour encourager l’adoption des véhicules électriques dans les entreprises.

Un Secteur en Croissance Dynamique

Cette prolongation intervient à un moment clé, alors que le marché des voitures électriques continue d’afficher une croissance remarquable. Entre 2020 et 2022, la progression annuelle moyenne a atteint 35%. En 2023, les particuliers représentent désormais 84% des acquisitions de véhicules électriques, contre seulement 68% en 2018.

Concrètement,cette mesure permet aux sociétés d’installer gratuitement des bornes de recharge pour leurs employés sans impact fiscal. Les frais liés à l’électricité pour ces recharges ne seront pas pris en compte dans le calcul des avantages en nature. De plus, un abattement de 50% sur ces avantages est maintenu avec un plafond révisé à environ 2000 euros pour l’année prochaine.

Accélération Vers une Mobilité Électrique

Cette initiative fait partie d’une stratégie globale visant à promouvoir l’électrification du parc automobile français. Cependant, les grandes entreprises rencontrent encore des difficultés pour atteindre leurs objectifs ; seulement 8% des nouveaux véhicules immatriculés par ces entités étaient électriques en 2023. Ces incitations fiscales pourraient néanmoins inciter davantage d’employeurs à franchir le pas.Cependant, plusieurs défis demeurent concernant les infrastructures nécessaires au chargement ainsi que sur l’autonomie des véhicules et les perceptions parmi les employés. Par ailleurs, la réduction progressive du bonus écologique pour les utilitaires et sa diminution pour les particuliers pourraient freiner cet élan vers une adoption plus large.

Avenir Prometteur Pour La Mobilité Électrique

Malgré ces obstacles potentiels, il existe un optimisme quant au futur de la mobilité électrique dans le milieu professionnel. Les avancées technologiques continues ainsi qu’un engagement croissant envers la durabilité devraient continuer à favoriser cette tendance vers une adoption accrue des véhicules écologiques.

En maintenant ces mesures fiscales avantageuses jusqu’en 2025 et au-delà, le gouvernement délivre un message fort soutenant la transition écologique dans le secteur du transport. Reste maintenant à voir si cela suffira réellement à convaincre certaines entreprises hésitantes et si cela permettra d’accélérer significativement l’électrification de leurs flottes professionnelles dans un avenir proche.

Divertissement

« À la rencontre d’un Hugo : une aventure inattendue »

Le prénom, un véritable reflet de notre identité, peut être à la fois lourd à porter et source de fierté. Dans cette chronique fascinante, le réalisateur Hugo David nous plonge dans son expérience avec un prénom très répandu. Né en 2000, il se retrouve entouré d’autres Hugo, ce qui l’amène à adopter un alias : Hugo D.. Comment ce choix a-t-il influencé son parcours ? Explorez les nuances et les histoires derrière nos prénoms et découvrez comment ils façonnent nos vies dès l’enfance jusqu’à l’âge adulte !

Les Prénoms : Un Voyage au Cœur de l’Identité

Le Rôle Crucial des Prénoms dans nos Existences

Chaque personne possède un prénom, qu’il soit courant ou singulier, et ce dernier peut engendrer à la fois fierté et embarras. Cet article explore la signification profonde et l’influence des prénoms sur notre vie quotidienne. Le réalisateur Hugo David partage son vécu avec un prénom qui a connu une forte popularité durant sa jeunesse.

une Naissance Sous le Signe de la Célébrité

Hugo David est né en 2000 à Tours, une époque où le prénom Hugo était en plein essor. Ses parents, Caroline et Rodolphe, avaient envisagé d’autres choix comme Enzo, également très en vogue à cette période. « Je pense que mes parents ont opté pour un prénom parmi les plus répandus en France plutôt qu’en hommage à Victor Hugo », confie-t-il.

Une Enfance Entourée d’Autres « Hugo »

Dès son plus jeune âge, Hugo se retrouve entouré d’autres enfants portant le même nom. Selon les statistiques de l’Insee,7 694 garçons ont été prénommés Hugo en 2000,faisant de ce prénom le quatrième plus populaire cette année-là. À l’école primaire,il côtoie plusieurs camarades appelés Thibault et autres prénoms similaires. Pour éviter toute confusion lors des appels en classe, les enseignants ajoutent souvent la première lettre du nom de famille après le prénom : ainsi devient-il rapidement « Hugo D. », un surnom auquel il s’habitue sans arduousé.

Pensées sur l’Identité Associée au Prénom

Le choix d’un prénom peut avoir un impact significatif sur notre identité personnelle tout au long de notre existence. Que ce soit pour se distinguer ou pour s’intégrer dans un groupe social spécifique, chaque individu développe une relation particulière avec son propre nom.

les prénoms ne sont pas simplement des désignations ; ils portent avec eux des récits et influencent nos interactions sociales depuis notre enfance jusqu’à l’âge adulte.

-

Business1 an ago

Business1 an agoComment lutter efficacement contre le financement du terrorisme au Nigeria : le point de vue du directeur de la NFIU

-

Général2 ans ago

Général2 ans agoX (anciennement Twitter) permet enfin de trier les réponses sur iPhone !

-

Technologie1 an ago

Technologie1 an agoTikTok revient en force aux États-Unis, mais pas sur l’App Store !

-

Général1 an ago

Général1 an agoAnker SOLIX dévoile la Solarbank 2 AC : la nouvelle ère du stockage d’énergie ultra-compatible !

-

Général1 an ago

Général1 an agoLa Gazelle de Val (405) : La Star Incontournable du Quinté d’Aujourd’hui !

-

Sport1 an ago

Sport1 an agoSaisissez les opportunités en or ce lundi 20 janvier 2025 !

-

Business1 an ago

Business1 an agoUne formidable nouvelle pour les conducteurs de voitures électriques !

-

Science et nature1 an ago

Science et nature1 an agoLes meilleures offres du MacBook Pro ce mois-ci !