Santé et médecine

Le NIST dévoile une nouvelle plateforme open source révolutionnaire pour évaluer la sécurité de l’IA !

Découvrez Dioptra, un outil révolutionnaire et gratuit qui aide les développeurs d’intelligence artificielle à naviguer dans les risques uniques liés aux modèles d’IA. Selon le directeur du NIST, cet outil vise à atténuer ces risques tout en favorisant l’innovation. Dans un contexte où la sécurité des systèmes d’IA est primordiale, Dioptra permet aux organisations de santé et autres de mieux comprendre leurs logiciels d’IA face à des attaques adversariales. Ne manquez pas cette opportunité d’évaluer la performance de vos modèles et de garantir leur fiabilité !

Outil Dioptra : Une avancée pour la sécurité des modèles d’IA

Introduction à Dioptra

Un nouvel outil open source, nommé Dioptra, a été mis à disposition pour aider les développeurs d’intelligence artificielle à identifier et à gérer les risques spécifiques associés aux modèles d’IA. Selon le directeur du NIST, cet outil vise à « atténuer ces risques tout en soutenant l’innovation ».

Contexte et Importance

Près d’un an après que l’administration Biden a émis un décret exécutif sur le développement sûr et fiable de l’IA, le National Institute of Standards and Technology (NIST) a lancé cet outil pour tester la sécurité des modèles d’IA et d’apprentissage automatique. Dioptra répond à une nécessité soulignée dans le décret, qui demande au NIST de jouer un rôle actif dans l’évaluation des algorithmes.

Comprendre les Risques des Modèles d’IA

Les chercheurs du NIST soulignent qu’une des vulnérabilités majeures d’un système d’IA réside dans le modèle lui-même. En exposant un modèle à de grandes quantités de données d’entraînement, il apprend à prendre des décisions. Cependant, si des adversaires altèrent ces données avec des informations erronées – par exemple, en introduisant des données qui amènent le modèle à confondre des panneaux de stop avec des panneaux de limite de vitesse – cela peut entraîner des décisions incorrectes et potentiellement catastrophiques.

Objectifs de Dioptra

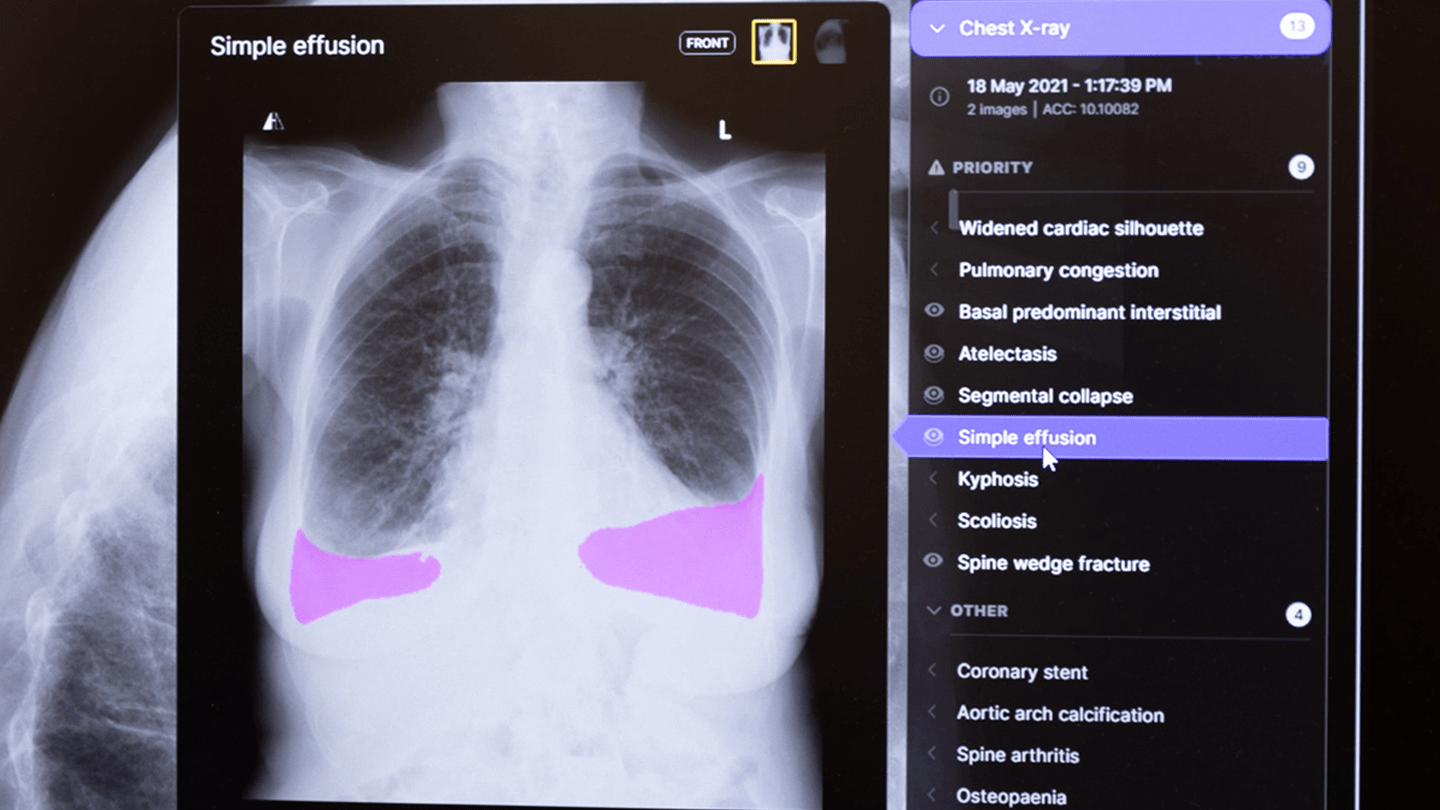

L’objectif principal de Dioptra est d’aider les organisations, notamment dans le secteur de la santé, à mieux comprendre leurs logiciels d’IA et à évaluer leur résistance face à divers types d’attaques malveillantes. Cet outil, disponible gratuitement, pourrait permettre aux prestataires de soins de santé, aux entreprises et aux agences gouvernementales de vérifier les promesses des développeurs d’IA concernant les performances de leurs modèles.

Fonctionnalités de l’Outil

Dioptra permet aux utilisateurs d’identifier les types d’attaques qui pourraient nuire à l’efficacité du modèle et de quantifier la réduction de performance. Cela aide les utilisateurs à comprendre à quelle fréquence et dans quelles conditions le système pourrait échouer.

Tendances Actuelles

En plus du lancement de Dioptra, l’Institut de sécurité de l’IA du NIST a récemment publié des directives préliminaires sur la gestion des risques d’utilisation abusive des modèles de base à double usage. Ces modèles, qui peuvent être bénéfiques ou nuisibles, présentent des risques pour la sécurité s’ils sont mal utilisés. Les nouvelles recommandations décrivent sept approches clés pour atténuer ces risques, ainsi que des conseils sur leur mise en œuvre et la transparence.

Initiatives Complémentaires

Le NIST a également finalisé trois documents sur la sécurité de l’IA, axés sur la réduction des risques liés à l’IA générative, la protection des données utilisées pour former les systèmes d’IA et l’engagement mondial sur les normes d’IA. Parallèlement, des efforts sont en cours au niveau fédéral pour établir des protections pour l’IA dans le secteur de la santé et au-delà, y compris une réorganisation majeure au sein du Département de la santé et des services sociaux.

Engagement du Gouvernement

Le gouvernement a également mis en place de nouvelles règles concernant l’utilisation de l’IA dans les agences fédérales, y compris les CDC et les hôpitaux de la VA. Le NIST travaille également sur d’autres initiatives liées à l’IA et à la sécurité, telles que des directives sur la protection de la vie privée pour la recherche alimentée par l’IA et une mise à jour significative de son cadre de cybersécurité.

Conclusion

« Malgré ses avantages potentiels transformateurs, l’IA générative présente également des risques qui diffèrent considérablement de ceux que nous observons avec les logiciels traditionnels », a déclaré Laurie E. Locascio, directrice du NIST. « Ces documents de directives et cette plateforme de test informeront les créateurs de logiciels sur ces risques uniques et les aideront à développer des moyens de les atténuer tout en soutenant l’innovation. »

Gina Raimondo, secrétaire américaine au Commerce, a ajouté : « L’IA est la technologie déterminante de notre génération, et nous agissons rapidement pour garantir le développement et le déploiement sûrs de l’IA. Ces annonces démontrent notre engagement à fournir aux développeurs, déployeurs et utilisateurs d’IA les outils nécessaires pour exploiter en toute sécurité le potentiel de l’IA tout en minimisant les risques associés. »

Général

Le Rotary investit 2 millions de dollars pour la santé maternelle : le président de la Fondation en visite au Nigeria pour explorer de nouvelles opportunités

Erreur 403 : Accès refusé !

Vous êtes face à un mur numérique. Impossible d’accéder à ce document, et la frustration monte. Que faire dans ces moments-là ? Ne paniquez pas ! Voici quelques solutions simples :

- Cliquez sur « Recharger la page »

- Passez à la page précédente

- Retournez à l’accueil

N’oubliez pas, chaque obstacle est une opportunité d’explorer de nouvelles voies !

Erreur de Serveur : Accès Refusé

Vous n’avez pas l’autorisation d’accéder à ce document.

Voici quelques actions possibles :

Rafraîchir la page

Retourner à la page précédente

Accéder à la page d’accueil

Santé et médecine

Les refuges d’Ottawa : Dîners festifs et cadeaux pour les résidents pendant les fêtes !

Le jour de Noël, les Pasteurs de la Bonne Espérance ont accueilli des centaines de personnes pour un repas festif chaleureux. Azery Sharrons, un homme de 70 ans vivant au refuge, a exprimé sa gratitude pour ce repas qui lui rappelle des souvenirs d’enfance. Husa Delice, un bénévole dévoué depuis 2022, a souligné l’importance de cette communauté où les sourires et la chaleur humaine règnent. Ce Noël n’était pas seulement une fête; c’était une occasion d’unir ceux qui en ont besoin et d’apporter un peu de réconfort dans leurs vies difficiles.

Célébrations de Noël au Refuge des Bons Samaritains

un repas chaleureux pour les plus démunis

Le jour de Noël, le Refuge des Bons samaritains a accueilli un grand nombre de personnes pour un repas fait maison. Les organisateurs s’attendaient à servir plusieurs centaines de convives tout au long de la journée.

L’engagement des bénévoles

Husa Delice, bénévole depuis 2022, a partagé son expérience en disant que cet endroit était « merveilleux » et lui avait permis de rencontrer des gens formidables. Il a remarqué que les membres de la communauté étaient »heureux » et « sourire aux lèvres ».

Une atmosphère conviviale malgré le froid

Delice a souligné l’importance d’offrir chaleur et réconfort aux personnes dans le besoin pendant cette période froide. Azery Sharrons, un homme âgé de 70 ans vivant dans une zone d’accueil du refuge, a exprimé sa gratitude pour le repas copieux qui rappelait les traditions festives.

Activités post-Noël au refuge

Le lendemain du jour de Noël, le refuge prévoit d’accueillir un groupe de chanteurs qui viendront égayer l’après-midi avec des chants traditionnels. Des dons tels que vêtements chauds et produits d’hygiène seront également distribués aux visiteurs.

Besoins matériels essentiels

Les dons comme tasses, assiettes et couverts sont cruciaux pour la cuisine communautaire. De plus, les couvertures et oreillers sont très appréciés par ceux qui séjournent au refuge.

Élargissement des festivités

En parallèle à ces activités sur leur site principal rue Murray, l’équipe du Refuge des Bons Samaritains s’est rendue dans cinq résidences offrant un logement soutenu afin d’y servir également le dîner traditionnel ainsi que distribuer des cadeaux.

Préparatifs minutieux en cuisine

Peter Gareau, responsable du service alimentaire au refuge, a expliqué qu’une préparation intensive est nécessaire avant Noël.Bien qu’il ait initialement craint ne pas avoir assez de dindes à cause du nombre élevé attendu, il a été soulagé par la générosité locale qui lui a permis d’obtenir suffisamment pour nourrir tous les invités durant toute la semaine.

Gareau souligne aussi que ces repas festifs peuvent raviver chez certains clients des souvenirs heureux liés à leur enfance : « Personne ne choisit ce mode de vie », dit-il en espérant que cela puisse inciter certains à participer aux programmes offerts par l’établissement.

Autres initiatives communautaires

D’autres organisations ont également organisé leurs propres célébrations durant cette période festive.Cornerstone Housing for Women par exemple avait prévu une collecte communautaire permettant la création de 321 sacs-cadeaux destinés aux résidents en situation précaire.

Chris O’Gorman mentionne que ces gestes montrent clairement aux bénéficiaires qu’ils sont soutenus par leur communauté. En collaboration avec Restaurant 18, ils ont préparé plusieurs centaines de plats traditionnels pour ceux vivant dans leurs installations.

Dons inattendus

De son côté Peter Tilley, directeur général du Ottawa Mission (Mission d’Ottawa), raconte comment ils ont reçu plus de 200 dons provenant d’un groupe appelé Backpacks for the Homeless (Sacs à dos pour sans-abri). Ces paquets contenaient divers articles allant des chaussettes jusqu’à une carte-cadeau Tim Hortons.

Tilley ajoute qu’ils ont ouvert leur chapelle toute la journée afin que ceux qui se sentent seuls puissent regarder tranquillement quelques films classiques tout en profitant ainsi d’un moment réconfortant pendant cette période difficile.

Santé et médecine

Les étoiles de Downton Abbey : que sont-elles devenues depuis la fin de la série ?

Il y a presque neuf ans, Downton Abbey a tiré sa révérence sur ITV, mais l’héritage de cette série emblématique perdure. Grâce à deux films et un troisième en cours de tournage, les fans peuvent retrouver leurs personnages préférés. Hugh Bonneville, Michelle Dockery et Joanne Froggatt ont continué à briller sur nos écrans avec des rôles captivants. Découvrez ce que ces acteurs talentueux ont accompli depuis la fin de la série et comment ils ont évolué au fil des années. La magie de Downton Abbey n’est pas prête de s’éteindre !

Medecine

Le temps passe vite, cela fait déjà neuf ans que la série Downton Abbey a pris fin sur ITV. Heureusement,cette franchise a donné naissance à deux films,et un troisième a été tourné cet été.

Depuis la conclusion de la série, nous avons eu le plaisir de voir les acteurs reprendre leurs rôles emblématiques, bien que quelques exceptions notables soient à signaler. Bien que nous n’ayons jamais vraiment dit adieu aux personnages, beaucoup de choses ont évolué pour Hugh Bonneville, Michelle Dockery, Joanne Froggatt et d’autres depuis leur passage dans l’émission. Voici un aperçu de ce qu’ils ont réalisé au cours des presque dix dernières années…

### Hugh Bonneville : Un parcours diversifié

Hugh Bonneville est reconnu pour son interprétation du comte Robert Crawley. Après la fin de Downton Abbey, il a continué à briller sur nos écrans dans la franchise Paddington, tout en décrochant des rôles dans des productions telles que I Came By (2022), Bank of Dave (2023) et le prochain film intitulé douglas is Cancelled, prévu pour 2024.

Cet été, Hugh a également participé au tournage du troisième film de la saga Downton Abbey qui n’a pas encore reçu son titre officiel.

### Michelle Dockery : Des rôles audacieux

Michelle Dockery continue d’incarner Lady Mary Crawley avec brio tout en s’attaquant à des rôles plus sombres et complexes. Parmi ses récentes apparitions télévisées figurent les séries godless (2017), Anatomy of a Scandal (2022) et le futur projet intitulé This Town, prévu pour 2024. Au cinéma, elle est apparue dans des films tels que The Gentlemen (2019), ainsi que dans les productions récentes comme Boy kills World (2023) et le très attendu film < em >Flight Risk (2024).

### Joanne Froggatt : Une carrière florissante

Joanne Froggatt est devenue célèbre grâce à son rôle d’Anna Bates dans la série acclamée ainsi que dans ses adaptations cinématographiques. Depuis l’arrêt du show en 2015, elle a obtenu des premiers rôles dans plusieurs séries télévisées telles que < em >Liar (2017-20), < em >Angela Black (2021) et < em >Breathtaking (prévu pour 2024). Récemment confirmée pour participer à une nouvelle série criminelle sans titre réalisée par Guy Ritchie aux côtés de Tom Hardy et Pierce brosnan.

### Jessica Brown findlay : Une étoile montante

Jessica Brown Findlay s’est fait connaître en incarnant Lady Sybil Branson avant de quitter Downton Abbey en 2012. Depuis lors, elle a joué dans plusieurs productions notables comme < em >jamaica Inn (2014), < em >Harlots (2017-19), ainsi qu’< emp >Brave New World (2020). Son dernier projet inclut une apparition prévue dans la série télévisée Playing Nice avec James Norton qui sortira le 5 janvier prochain.

### Laura Carmichael : L’artiste polyvalente

Laura Carmichael s’est illustrée par sa performance remarquable en tant qu’Edith Crawley. elle continue d’apporter sa touche unique au petit écran avec notamment son rôle marquant en tant que Margaret Pole dans < emp>The Spanish princess (2019-20) ou Agatha dans < emp>The Secrets She Keeps .

### Jim Carter : Un acteur prolifique

Jim Carter ne chôme pas ! après l’arrêt de Downton Abbey , il est apparu sur scène notamment avec sa participation remarquée à king Lear (2018) ou encore The Good Liar (2019). Plus récemment il était présent au cinéma avec The Sea Beast (2022) puis Wonka (prévu pour 2023).

### Penelope Wilton : Une carrière impressionnante

Penelope Wilton est célébrée pour son interprétation d’Isobel Gray .Sa filmographie comprend diverses œuvres telles que The Guernsey Literary and Potato Peel Pie Society(2018), After Life(2019-22 ), Operation Mincemeat( prévus cette année )et The Unlikely Pilgrimage of Harold fry( également prévu cette année ).

### Hommage à Dame Maggie Smith

Maggie Smith brillait sous les traits puissants de Violet Crawley , Comtesse douairière de Grantham . En plus d’avoir repris ce rôle iconique lors des films suivants,

Parmi ses nombreux projets récents figurent Sherlock Gnomes(18 ), A Boy Called Christmas(en21 )etThe Miracle Club(en23 ). Malheureusement,maggie nous a quittés le27 septembre dernierà l’âgede89 ans,soulevant une vagued’hommages émouvantsde lamisde Downtown.

-

Business1 an ago

Business1 an agoComment lutter efficacement contre le financement du terrorisme au Nigeria : le point de vue du directeur de la NFIU

-

Général2 ans ago

Général2 ans agoX (anciennement Twitter) permet enfin de trier les réponses sur iPhone !

-

Technologie1 an ago

Technologie1 an agoTikTok revient en force aux États-Unis, mais pas sur l’App Store !

-

Général1 an ago

Général1 an agoAnker SOLIX dévoile la Solarbank 2 AC : la nouvelle ère du stockage d’énergie ultra-compatible !

-

Général1 an ago

Général1 an agoLa Gazelle de Val (405) : La Star Incontournable du Quinté d’Aujourd’hui !

-

Sport1 an ago

Sport1 an agoSaisissez les opportunités en or ce lundi 20 janvier 2025 !

-

Business1 an ago

Business1 an agoUne formidable nouvelle pour les conducteurs de voitures électriques !

-

Science et nature1 an ago

Science et nature1 an agoLes meilleures offres du MacBook Pro ce mois-ci !