Technologie

Les décisions de fin de vie : un défi émotionnel, l’IA peut-elle apporter son aide ?

Dans un monde où les décisions médicales peuvent être déchirantes, un nouvel outil basé sur l’intelligence artificielle pourrait transformer la manière dont nous prenons ces choix cruciaux. Imaginez un jumeau numérique qui pourrait prédire les préférences d’un patient en se basant sur ses données personnelles. Ce projet, dirigé par des bioéthiciens, vise à alléger le fardeau émotionnel des proches confrontés à des décisions de fin de vie. Mais la question demeure : peut-on vraiment faire confiance à une machine pour des choix aussi intimes ?

Technologie

Un incident marquant s’est produit il y a quelques mois lorsqu’une femme d’une cinquantaine d’années, que nous appellerons Sophie, a subi un AVC hémorragique. Son cerveau a commencé à saigner, nécessitant une intervention chirurgicale. Malheureusement, son cœur a cessé de battre pendant l’opération.

L’épreuve de Sophie a entraîné des dommages cérébraux considérables. Elle est devenue non réactive, incapable de serrer les doigts ou d’ouvrir les yeux sur demande, et ne réagissait même pas lorsqu’on pinçait sa peau. Elle a dû être équipée d’une trachéotomie pour respirer et d’une sonde d’alimentation pour recevoir des nutriments directement dans l’estomac, car elle ne pouvait pas avaler. Quelle direction devait prendre son traitement médical à ce stade ?

Cette question délicate a été laissée, comme c’est souvent le cas dans de telles situations, aux membres de la famille de Sophie, se souvient Holland Kaplan, médecin en médecine interne au Baylor College of Medicine, qui a participé aux soins de Sophie. Cependant, la famille n’a pas réussi à se mettre d’accord. La fille de Sophie était convaincue que sa mère aurait voulu arrêter les traitements médicaux et mourir paisiblement. Un autre membre de la famille était en désaccord total, affirmant que Sophie était « une battante ». La situation était éprouvante pour tous, y compris pour les médecins de Sophie.

Prendre des décisions de fin de vie peut être extrêmement éprouvant pour les proches, ceux qui doivent faire ces choix au nom d’une autre personne, explique David Wendler, bioéthicien aux National Institutes of Health des États-Unis. Wendler et ses collègues travaillent sur une idée qui pourrait faciliter ces décisions : un outil basé sur l’intelligence artificielle qui aiderait les proches à prédire ce que le patient aurait voulu dans une situation donnée.

Cet outil n’est pas encore développé. Cependant, Wendler envisage de l’entraîner à partir des données médicales d’une personne, de ses messages personnels et de ses publications sur les réseaux sociaux. Il espère que cela pourrait non seulement être plus précis pour déterminer les souhaits du patient, mais aussi alléger le stress et le fardeau émotionnel des décisions difficiles pour les membres de la famille.

Wendler, avec le bioéthicien Brian Earp de l’Université d’Oxford et leurs collègues, espèrent commencer à construire cet outil dès qu’ils obtiendront un financement, potentiellement dans les mois à venir. Cependant, son déploiement ne sera pas simple. Les critiques s’interrogent sur l’éthique de l’entraînement d’un tel outil sur les données d’une personne et sur la question de savoir si des décisions de vie ou de mort devraient être confiées à l’IA.

Vivre ou mourir

Environ 34 % des personnes dans un cadre médical sont considérées comme incapables de prendre des décisions concernant leurs soins pour diverses raisons. Elles peuvent être inconscientes, par exemple, ou incapables de raisonner ou de communiquer. Ce chiffre est encore plus élevé chez les personnes âgées : une étude menée auprès de personnes de plus de 60 ans aux États-Unis a révélé que 70 % de celles confrontées à des décisions importantes concernant leurs soins manquaient de la capacité de prendre ces décisions elles-mêmes. « Il ne s’agit pas seulement d’un grand nombre de décisions, mais de décisions vraiment cruciales », déclare Wendler. « Des décisions qui déterminent essentiellement si la personne va vivre ou mourir dans un avenir proche. »

Les compressions thoraciques administrées à un cœur défaillant peuvent prolonger la vie d’une personne. Cependant, ce traitement peut entraîner des fractures du sternum et des côtes, et lorsque la personne reprend connaissance, si cela se produit, des dommages cérébraux significatifs peuvent déjà s’être développés. Maintenir le cœur et les poumons en fonctionnement à l’aide d’une machine peut assurer un approvisionnement en sang oxygéné pour les autres organes, mais la récupération n’est pas garantie, et la personne pourrait développer de nombreuses infections entre-temps. Une personne en phase terminale pourrait vouloir continuer à recevoir des médicaments et des procédures administrés par l’hôpital qui pourraient lui offrir quelques semaines ou mois supplémentaires. Mais une autre pourrait préférer renoncer à ces interventions et être plus à l’aise chez elle.

Seulement environ un adulte sur trois aux États-Unis remplit un document de directives anticipées, un document légal qui précise les soins de fin de vie qu’il pourrait souhaiter recevoir. Wendler estime que plus de 90 % des décisions de fin de vie finissent par être prises par quelqu’un d’autre que le patient. Le rôle d’un proche est de prendre cette décision en se basant sur ses croyances concernant la manière dont le patient aurait voulu être traité. Cependant, les gens ne sont généralement pas très doués pour faire ce genre de prédictions. Des études suggèrent que les proches prédisent avec précision les décisions de fin de vie d’un patient environ 68 % du temps.

Les décisions elles-mêmes peuvent également être extrêmement éprouvantes, ajoute Wendler. Alors que certains proches ressentent une satisfaction d’avoir soutenu leurs êtres chers, d’autres luttent avec le fardeau émotionnel et peuvent se sentir coupables pendant des mois, voire des années après. Certains craignent d’avoir mis fin à la vie de leurs proches trop tôt. D’autres s’inquiètent d’avoir prolongé inutilement leur souffrance. « C’est vraiment difficile pour beaucoup de gens », dit Wendler. « Les gens décrivent cela comme l’une des pires choses qu’ils aient jamais eu à faire. »

Wendler travaille sur des moyens d’aider les proches à prendre ce genre de décisions. Il y a plus de dix ans, il a développé l’idée d’un outil qui prédirait les préférences d’un patient en fonction de caractéristiques telles que l’âge, le sexe et le statut d’assurance. Cet outil aurait été basé sur un algorithme informatique entraîné sur des résultats d’enquête de la population générale. Cela peut sembler rudimentaire, mais ces caractéristiques semblent influencer la manière dont les gens perçoivent les soins médicaux. Par exemple, un adolescent est plus susceptible d’opter pour un traitement agressif qu’une personne de 90 ans. De plus, des recherches suggèrent que les prédictions basées sur des moyennes peuvent être plus précises que les suppositions faites par les membres de la famille.

En 2007, Wendler et ses collègues ont construit une version « très basique » et préliminaire de cet outil à partir d’un petit ensemble de données. Cet outil simpliste a « au moins aussi bien fonctionné que les proches » pour prédire le type de soins que les gens souhaiteraient, selon Wendler.

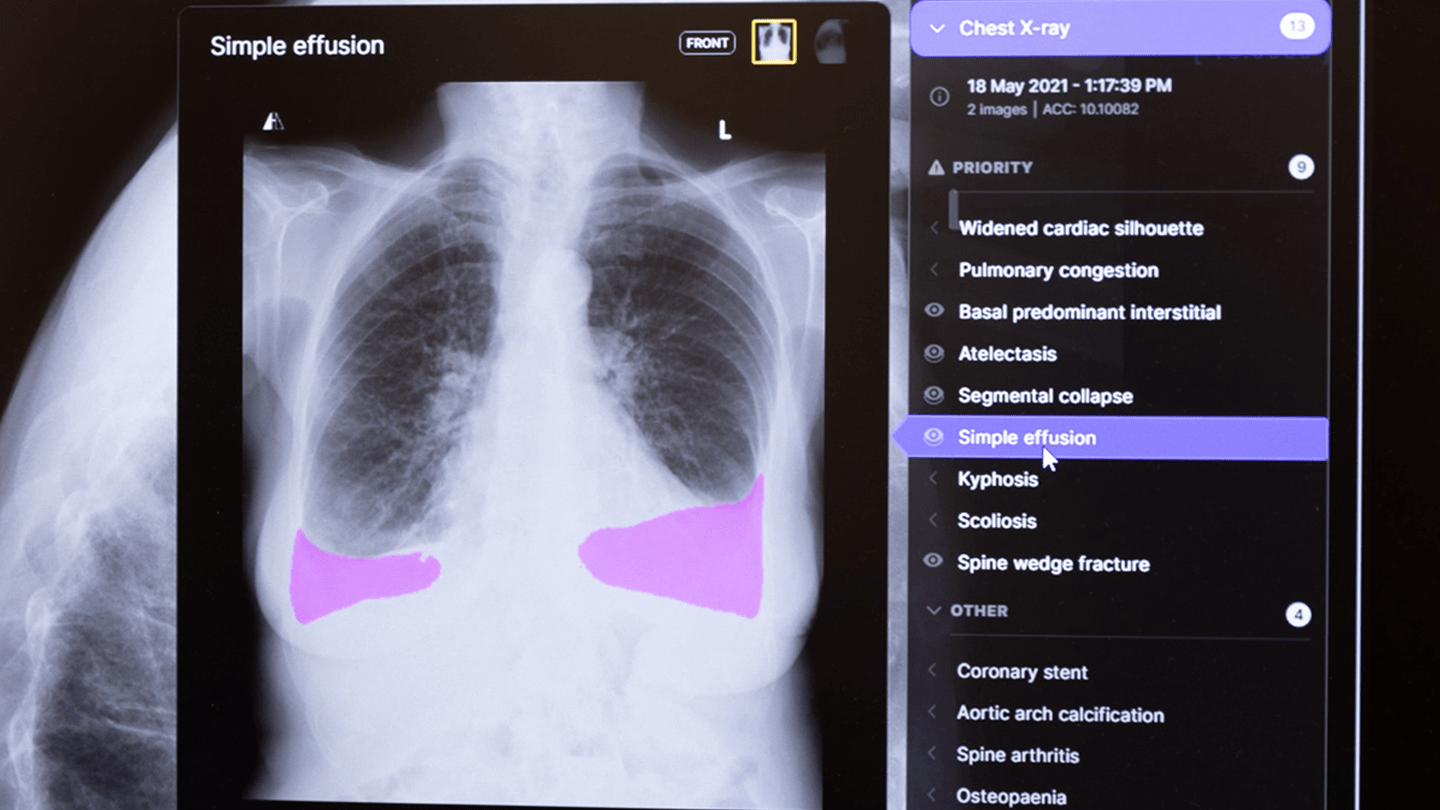

Aujourd’hui, Wendler, Earp et leurs collègues travaillent sur une nouvelle idée. Au lieu d’être basé sur des caractéristiques rudimentaires, le nouvel outil que les chercheurs envisagent de construire sera personnalisé. L’équipe propose d’utiliser l’IA et l’apprentissage automatique pour prédire les préférences de traitement d’un patient en fonction de données personnelles telles que l’historique médical, ainsi que des e-mails, des messages personnels, de l’historique de navigation sur le web, des publications sur les réseaux sociaux, ou même des « j’aime » sur Facebook. Le résultat serait un « jumeau psychologique numérique » d’une personne, un outil que les médecins et les membres de la famille pourraient consulter pour orienter les soins médicaux d’une personne. Il n’est pas encore clair à quoi cela ressemblerait en pratique, mais l’équipe espère construire et tester l’outil avant de l’affiner.

Les chercheurs appellent leur outil un prédicteur de préférences des patients personnalisé, ou P4 en abrégé. En théorie, s’il fonctionne comme ils l’espèrent, il pourrait être plus précis que la version précédente de l’outil et plus fiable que les proches, selon Wendler. Il pourrait également mieux refléter la pensée actuelle d’un patient qu’une directive anticipée, qui pourrait avoir été signée une décennie auparavant, selon Earp.

Une meilleure option ?

Un outil comme le P4 pourrait également aider à alléger le fardeau émotionnel que ressentent les proches lorsqu’ils prennent des décisions aussi significatives concernant la vie ou la mort de leurs membres de la famille, ce qui peut parfois laisser des symptômes de stress post-traumatique, explique Jennifer Blumenthal-Barby, éthicienne médicale au Baylor College of Medicine au Texas.

Certains proches éprouvent une « paralysie décisionnelle » et pourraient choisir d’utiliser l’outil pour les aider à naviguer dans le processus décisionnel, selon Kaplan. Dans de tels cas, le P4 pourrait contribuer à alléger une partie du fardeau que les proches pourraient ressentir, sans nécessairement leur fournir une réponse tranchée. Il pourrait, par exemple, suggérer qu’une personne était « probablement » ou « peu probable » de ressentir une certaine façon à propos d’un traitement, ou donner un score en pourcentage indiquant la probabilité que la réponse soit correcte ou incorrecte.

Kaplan peut imaginer un outil comme le P4 étant utile dans des cas comme celui de Sophie, où différents membres de la famille pourraient avoir des opinions divergentes sur les soins médicaux d’une personne. Dans de telles situations, l’outil pourrait être proposé à ces membres de la famille, idéalement.

Réflexions sur l’utilisation d’outils d’IA pour les décisions de fin de vie

Les décisions concernant les soins de fin de vie peuvent être particulièrement difficiles, surtout pour ceux qui n’ont pas de proches pour les représenter. Dans des établissements comme l’hôpital Ben Taub à Houston, qui sert de filet de sécurité pour les patients sans assurance, les médecins comme Kaplan rencontrent souvent des patients dans des situations critiques. Beaucoup d’entre eux sont sans abri, incarcérés ou sans papiers, et se retrouvent à un stade avancé de leur maladie, rendant la communication sur leurs souhaits de soins presque impossible.

Kaplan envisage l’utilisation d’outils comme le P4 pour aider à éclairer les décisions médicales dans ces contextes. Bien que trouver des informations sur les réseaux sociaux d’un patient puisse être difficile, d’autres données pourraient s’avérer utiles. Wendler, un chercheur impliqué dans le développement de ces outils, souligne l’importance d’inclure tout élément qui pourrait prédire les souhaits d’un patient, même des détails apparemment anodins comme la couleur de cheveux ou le nom de leur école primaire.

Acceptation et scepticisme face à l’IA

Des recherches préliminaires menées par Earp et son équipe montrent que certaines personnes pourraient être ouvertes à l’idée d’utiliser le P4, surtout en l’absence de représentants humains. Cependant, Earp lui-même admet qu’il privilégierait probablement l’avis d’un proche plutôt que celui d’un modèle d’IA si les deux différaient.

Cette hésitation est partagée par de nombreux experts. Georg Starke, chercheur à l’École polytechnique fédérale de Lausanne, s’inquiète de la tendance à transformer des décisions personnelles et complexes en simples problèmes techniques. Bryanna Moore, éthicienne à l’Université de Rochester, exprime également des réserves, soulignant que le soutien émotionnel et l’écoute active sont souvent plus nécessaires que des outils technologiques dans des moments de crise.

Les limites des outils d’IA

Moore reconnaît que même les proches ne prennent pas toujours les bonnes décisions. De plus, les souhaits d’un patient peuvent évoluer avec le temps, ce qui complique encore la situation. Elle évoque le dilemme du « soi d’hier » contre le « soi d’aujourd’hui », soulignant que même des directives antérieures peuvent ne pas refléter les désirs actuels d’un individu.

Les préoccupations ne s’arrêtent pas là. Un modèle d’IA basé sur les publications sur les réseaux sociaux d’une personne peut ne pas capturer fidèlement ses valeurs ou ses désirs réels. Blumenthal-Barby note que les utilisateurs de réseaux sociaux présentent souvent une version idéalisée d’eux-mêmes, ce qui complique la tâche de l’IA pour comprendre leurs véritables sentiments concernant les soins de fin de vie.

Les défis éthiques et pratiques

Les experts s’accordent à dire que l’IA ne fournit pas toujours des réponses fiables aux questions humaines. Même de légers changements dans les requêtes peuvent entraîner des réponses radicalement différentes. Starke souligne que cela pourrait être particulièrement problématique lorsqu’il s’agit de décisions aussi cruciales que celles de fin de vie.

Malgré ces défis, certains, comme Vasiliki Rahimzadeh, bioéthicienne au Baylor College of Medicine, estiment que le P4 pourrait être bénéfique, à condition qu’il soit rigoureusement testé. Earp et Wendler sont conscients des obstacles à surmonter et espèrent que leur outil pourra fournir des informations utiles tout en respectant la vie privée des patients.

Conséquences potentielles de l’utilisation du P4

Il existe des craintes quant à la manière dont un tel outil pourrait être utilisé. Par exemple, dans des situations tendues comme celle de Sophie, les prédictions du P4 pourraient exacerber des tensions familiales déjà présentes. Si les médecins se sentent légalement contraints de suivre les recommandations de l’IA plutôt que les souhaits des proches, cela pourrait créer des situations délicates et douloureuses pour les familles.

Wendler s’inquiète également de la possibilité que des hôpitaux utilisent des outils comme le P4 pour éviter des procédures coûteuses, ce qui soulève des questions éthiques sur les incitations financières. Tous les experts interrogés s’accordent à dire que l’utilisation d’un outil comme le P4 devrait rester une option, et que son adoption ne conviendrait pas à tout le monde. Earp conclut en affirmant que, bien que cela puisse être utile pour certains, beaucoup pourraient se sentir mal à l’aise à l’idée qu’un système artificiel influence des décisions aussi cruciales.

Général

Anker SOLIX dévoile la Solarbank 2 AC : la nouvelle ère du stockage d’énergie ultra-compatible !

Découvrez le Solarbank 2 AC, une véritable révolution dans le domaine de l’énergie solaire ! Grâce à ses batteries au phosphate de fer lithium, ce système s’adapte parfaitement à vos besoins. Avec une puissance impressionnante de 2400 watts et la possibilité d’ajouter jusqu’à cinq batteries supplémentaires, il assure un stockage optimal. Sa compatibilité avec le compteur Anker SOLIX Smart favorise une gestion intelligente de votre consommation énergétique. Ne ratez pas l’offre spéciale « early bird », disponible dès maintenant pour seulement 999 euros ! Saisissez cette chance unique !

Le Solarbank 2 AC : Une Révolution dans le Stockage Énergétique

Batteries au Lithium Fer Phosphate

Le Solarbank 2 AC se démarque par l’utilisation de batteries au lithium fer phosphate (LFP), reconnues pour leur sécurité et leur efficacité. Ce modèle est particulièrement innovant grâce à son système de couplage alternatif, qui lui permet de s’adapter facilement à divers systèmes solaires déjà en place.Que ce soit pour des installations sur toiture, des systèmes solaires compacts pour balcons ou d’autres configurations réduites, il peut fonctionner avec un micro-onduleur de 800 Watts.

Capacité et flexibilité Énergétique

Avec une capacité maximale d’injection dans le réseau domestique atteignant 1200 watts,le Solarbank 2 AC peut être associé à deux régulateurs solaires MPPT. Cela ouvre la possibilité d’ajouter jusqu’à 1200 watts supplémentaires via des panneaux solaires additionnels, portant ainsi la puissance totale à un impressionnant 2400 watts. Pour les utilisateurs nécessitant davantage de stockage énergétique, il est possible d’intégrer jusqu’à cinq batteries supplémentaires de 1,6 kilowattheure chacune, augmentant la capacité totale à 9,6 kilowattheures.

Intégration dans un Écosystème Intelligent

Le Solarbank 2 AC s’intègre parfaitement dans un écosystème énergétique intelligent grâce à sa compatibilité avec le compteur Anker SOLIX Smart et les prises intelligentes proposées par Anker. cette fonctionnalité permet une gestion optimisée de la consommation électrique tout en réduisant les pertes énergétiques inutiles. De plus, Anker SOLIX prévoit d’étendre cette compatibilité aux dispositifs Shelly.

Durabilité et Résistance aux Intempéries

Anker SOLIX met également l’accent sur la longévité du Solarbank 2 AC. Conçu pour supporter au moins 6000 cycles de charge, cet appareil a une durée de vie estimée dépassant quinze ans. Il est accompagné d’une garantie fabricant décennale et possède une certification IP65 qui assure sa résistance face aux intempéries tout en étant capable de fonctionner dans des températures variant entre -20 °C et +55 °C.

Disponibilité et Offres Promotionnelles

Le solarbank 2 AC est disponible sur le site officiel d’Anker SOLIX ainsi que sur Amazon au prix standard de 1299 euros. Cependant, une offre promotionnelle « early bird » sera active du 20 janvier au 23 février 2025, permettant aux acheteurs intéressés d’acquérir cet appareil dès 999 euros ! Cette promotion inclut également un compteur Anker SOLIX Smart offert pour chaque commande passée durant cette période spéciale.

le Solarbank 2 AC représente une avancée significative dans le domaine du stockage énergétique domestique grâce à ses caractéristiques techniques avancées et son engagement envers la durabilité environnementale.

Technologie

Ne manquez pas cette offre incroyable : le Air Fryer Moulinex Easy Fry Max à -42% sur Amazon !

Les soldes d’hiver sont là ! Ne ratez pas l’incroyable offre d’Amazon sur le Moulinex Easy Fry Max, à seulement 69 euros au lieu de 119 euros, soit une réduction sensationnelle de -42% ! Avec sa capacité généreuse de 5 L, cette friteuse sans huile est idéale pour régaler jusqu’à 6 convives. Grâce à ses 10 programmes de cuisson et son interface tactile intuitive, préparez des plats sains et savoureux en un clin d’œil. Dépêchez-vous, les stocks s’épuisent vite et cette offre est limitée dans le temps !

Technologie

Les soldes d’hiver sont en cours, et Amazon en profite pour offrir des promotions intéressantes, notamment sur les friteuses à air. Actuellement, le Moulinex Easy Fry Max est proposé à un prix attractif de 69 euros au lieu de 119 euros, ce qui représente une réduction immédiate de 42 %. C’est une occasion parfaite pour acquérir une friteuse sans huile XL d’une capacité généreuse de 5 L, idéale pour préparer des repas pour jusqu’à six personnes à un tarif très compétitif.

Étant donné que cette offre est limitée dans le temps,il est conseillé d’agir rapidement si vous souhaitez en bénéficier. De plus, avec un tel prix, les stocks pourraient s’épuiser rapidement. Ce modèle se classe parmi les meilleures ventes sur Amazon avec plus de 1000 unités écoulées le mois dernier.

Profitez des offres sur Amazon

Amazon propose également la livraison gratuite et rapide pour cet article qui bénéficie d’une garantie de deux ans. En outre, il existe une option de paiement échelonné en quatre fois sans frais sur ce modèle. Enfin, sachez que vous avez la possibilité de changer d’avis et retourner le produit gratuitement dans un délai de 30 jours afin d’obtenir un remboursement intégral.

Moulinex Easy Fry Max : cuisinez sainement pour toute la famille

Le moulinex Easy Fry Max fonctionne comme un four à air chaud permettant la préparation de plats savoureux tout en utilisant peu ou pas du tout d’huile. En plus des frites croustillantes qu’il réalise parfaitement, cet appareil se révèle très polyvalent et peut cuisiner une multitude d’autres recettes.

avec ses dix programmes prédéfinis adaptés à divers ingrédients tels que poulet,steak,poisson ou légumes ainsi que des options pour bacon et desserts comme les pizzas ,cet appareil répond aux besoins variés des familles modernes. De plus, Moulinex met à disposition un livre numérique rempli de recettes accessible via QR Code afin que vous puissiez facilement trouver l’inspiration culinaire lorsque nécessaire.

Sa capacité généreuse permet non seulement la préparation rapide mais aussi économique : jusqu’à 70 % moins énergivore et presque deux fois plus rapide qu’un four traditionnel ! Son interface intuitive avec écran tactile facilite son utilisation quotidienne.

en outre, le panier antiadhésif compatible lave-vaisselle simplifie grandement l’entretien après chaque utilisation. N’oubliez pas qu’il s’agit là encore d’une offre temporaire ; ne tardez donc pas si vous souhaitez profiter du meilleur prix possible sur cette friteuse innovante !

Pour accéder à cette remise exceptionnelle :

Technologie

TikTok revient en force aux États-Unis, mais pas sur l’App Store !

Le suspense autour de TikTok est à son comble ! En avril 2024, le Congrès américain a voté une loi obligeant l’application à changer de propriétaire avant le 19 janvier. Les utilisateurs ont anxieusement attendu la décision finale. Bien que TikTok ait brièvement cessé ses activités, elle est revenue en ligne, mais absente de l’App Store. Apple justifie cette décision par des obligations légales. Cependant, les utilisateurs peuvent toujours accéder à leur compte… sans mises à jour. L’avenir de TikTok pourrait prendre un tournant décisif avec les promesses du nouveau président.

Technologie

En avril 2024, le Congrès américain a adopté une législation obligeant TikTok à trouver un nouvel acquéreur, ByteDance étant accusé d’activités d’espionnage. Les utilisateurs de l’submission aux États-Unis ont donc attendu avec impatience le week-end précédent la date limite du 19 janvier pour savoir si TikTok serait interdit dans le pays.

Bien que TikTok n’ait pas réussi à dénicher un repreneur avant cette échéance, l’application a temporairement suspendu ses activités… mais seulement pour quelques heures. le réseau social est désormais de retour en ligne, mais il n’est plus accessible sur l’App Store.

Retour de TikTok : Une Absence Persistante sur l’App Store

Apple a expliqué sa décision de retirer TikTok de son App store par un communiqué officiel. « Apple doit respecter les lois en vigueur dans les régions où elle opère. Selon la loi Protecting Americans from Foreign Adversary Controlled Applications act, les applications développées par ByteDance ltd., y compris TikTok et ses filiales comme CapCut et Lemon8, ne pourront plus être téléchargées ou mises à jour sur l’App Store pour les utilisateurs américains après le 19 janvier 2025 », précise la société.

Il est crucial de souligner que les utilisateurs américains ayant déjà installé TikTok peuvent toujours accéder au service. Cependant, ils ne recevront plus aucune mise à jour future de l’application. L’avenir du réseau social pourrait dépendre des décisions du nouveau président des États-Unis.

DÉCLARATION DE TIKTOK :

>

En collaboration avec nos partenaires techniques, nous travaillons activement à rétablir notre service. Nous remercions le président Trump pour avoir clarifié la situation et rassuré nos partenaires qu’ils ne subiront aucune sanction en continuant d’offrir TikTok aux plus de 170 millions d’utilisateurs…

Le successeur de Joe Biden sera investi comme président ce lundi 20 janvier et prévoit d’émettre un décret afin d’accorder un délai supplémentaire à TikTok pour trouver un acquéreur potentiel.Donald Trump propose même que les États-Unis détiennent une participation significative dans cette application.

« Je souhaite que les États-Unis possèdent une part importante dans une coentreprise avec cet outil numérique afin que nous puissions préserver son intégrité tout en lui permettant d’évoluer […]. Ainsi,notre pays détiendrait la moitié des parts dans une coentreprise établie entre nous et tout acheteur sélectionné »,a déclaré Donald Trump.

L’avenir immédiat de TikTok pourrait donc connaître des évolutions majeures très prochainement. Il convient également de noter qu’une rumeur circulait selon laquelle Elon Musk envisagerait d’acquérir des parts dans la plateforme,mais celle-ci a été rapidement démentie par un porte-parole officiel.

-

Business1 an ago

Business1 an agoComment lutter efficacement contre le financement du terrorisme au Nigeria : le point de vue du directeur de la NFIU

-

Général2 ans ago

Général2 ans agoX (anciennement Twitter) permet enfin de trier les réponses sur iPhone !

-

Technologie1 an ago

Technologie1 an agoTikTok revient en force aux États-Unis, mais pas sur l’App Store !

-

Général1 an ago

Général1 an agoAnker SOLIX dévoile la Solarbank 2 AC : la nouvelle ère du stockage d’énergie ultra-compatible !

-

Général1 an ago

Général1 an agoLa Gazelle de Val (405) : La Star Incontournable du Quinté d’Aujourd’hui !

-

Sport1 an ago

Sport1 an agoSaisissez les opportunités en or ce lundi 20 janvier 2025 !

-

Business1 an ago

Business1 an agoUne formidable nouvelle pour les conducteurs de voitures électriques !

-

Science et nature1 an ago

Science et nature1 an agoLes meilleures offres du MacBook Pro ce mois-ci !