En 2023, Meta a présenté son premier accélérateur d’inférence AI conçu en interne, destiné à optimiser les modèles de classement et de recommandation qui sont essentiels pour Facebook et Instagram.

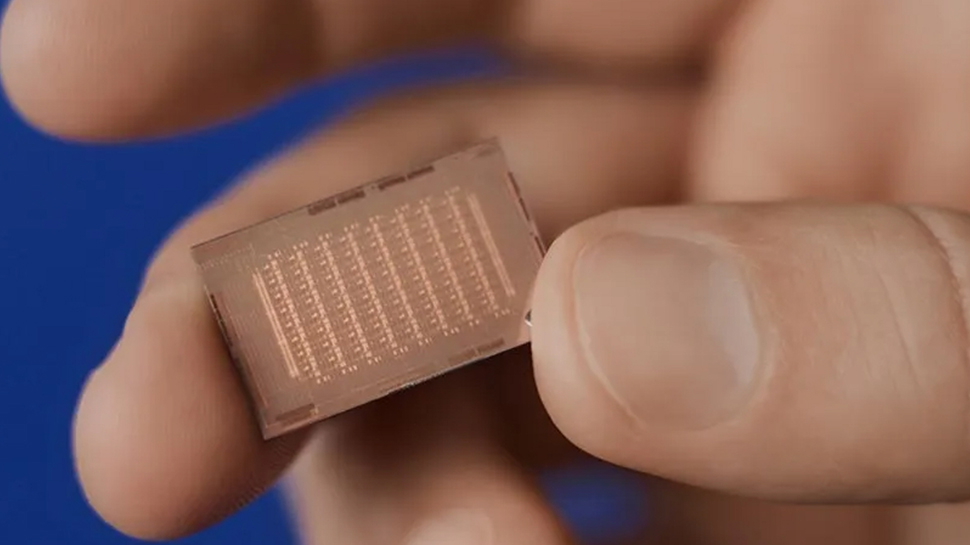

Le chip Meta Training and Inference Accelerator (MTIA), qui se concentre sur l’inférence plutôt que sur l’entraînement, a été mis à jour en avril, doublant ainsi la bande passante de calcul et de mémoire par rapport à la première version.

Lors du récent symposium Hot Chips, Meta a partagé des informations sur la prochaine génération de MTIA, tout en reconnaissant les défis liés à l’utilisation de GPU pour les moteurs de recommandation. Le géant des réseaux sociaux a souligné que la performance maximale ne se traduit pas toujours par une efficacité réelle, que les déploiements à grande échelle peuvent être gourmands en ressources, et que les contraintes de capacité sont accentuées par la demande croissante pour l’IA générative.

Amélioration des performances

Dans ce contexte, les objectifs de développement de Meta pour la prochaine génération de MTIA incluent une amélioration des performances par rapport au coût total de possession (TCO) et par watt, une gestion efficace des modèles à travers plusieurs services Meta, ainsi qu’une augmentation de l’efficacité des développeurs pour permettre des déploiements à grande échelle rapides.

Le dernier MTIA bénéficie d’une amélioration significative grâce à la technologie GEN-O-GEN, qui augmente les TOPs GEMM de 3,5 fois, atteignant 177 TFLOPS en BF16, tout en offrant une quantification tensorielle matérielle pour une précision comparable à FP32. De plus, il optimise le support pour le mode Eager de PyTorch, permettant des temps de lancement de tâches inférieurs à 1 microseconde et un remplacement de tâches en moins de 0,5 microseconde. L’optimisation TBE améliore également les temps de téléchargement et de préchargement des indices d’embedding, atteignant des temps d’exécution 2 à 3 fois plus rapides que la génération précédente.

Construit sur le processus 5nm de TSMC, le chip MTIA fonctionne à 1,35 GHz avec un total de 2,35 milliards de portes et offre des performances de 354 TOPS (INT8) et 177 TOPS (FP16) en GEMM, utilisant 128 Go de mémoire LPDDR5 avec une bande passante de 204,8 Go/s, le tout dans une enveloppe thermique de 90 watts.

Les éléments de traitement reposent sur des cœurs RISC-V, intégrant des extensions scalaires et vectorielles, et le module d’accélérateur de Meta comprend des CPU doubles. Lors de Hot Chips 2024, ServeTheHome a remarqué une expansion de mémoire liée au commutateur PCIe et aux CPU. Lorsqu’on lui a demandé si cela était lié à CXL, Meta a répondu de manière plutôt énigmatique : « c’est une option pour ajouter de la mémoire dans le châssis, mais cela n’est pas déployé actuellement. »

Autres actualités technologiques

- Meta a réalisé une avancée qui pourrait inquiéter Nvidia et AMD.

- Meta envisage d’utiliser des CPU exotiques et personnalisés dans ses centres de données pour l’IA.

- Meta a fourni plus de détails sur l’évolution de l’entraînement de Llama 3.

MTIA chip » data-original-mos= »https://tecknews.com/wp-content/uploads/2024/09/localimages/DQvohiARhJPLxVjSBiEPK5.jpg » data-pin-media= »https://tecknews.com/wp-content/uploads/2024/09/localimages/DQvohiARhJPLxVjSBiEPK5.jpg » data-pin-nopin= »true » fetchpriority= »high »>

MTIA chip » data-original-mos= »https://tecknews.com/wp-content/uploads/2024/09/localimages/DQvohiARhJPLxVjSBiEPK5.jpg » data-pin-media= »https://tecknews.com/wp-content/uploads/2024/09/localimages/DQvohiARhJPLxVjSBiEPK5.jpg » data-pin-nopin= »true » fetchpriority= »high »>