L’inférence d’IA à la périphérie désigne l’exécution de modèles d’apprentissage automatique (ML) formés à proximité des utilisateurs finaux, contrairement à l’inférence d’IA traditionnelle dans le cloud. Cette approche permet d’accélérer le temps de réponse des modèles ML, rendant possibles des applications d’IA en temps réel dans des secteurs tels que le jeu vidéo, la santé et le commerce de détail.

Qu’est-ce que l’inférence d’IA à la périphérie ?

Avant d’explorer l’inférence d’IA à la périphérie, il est essentiel de comprendre ce qu’est l’inférence d’IA en général. Dans le cycle de développement de l’IA/ML, l’inférence est le moment où un modèle ML formé effectue des tâches sur de nouvelles données, telles que faire des prédictions ou générer du contenu. L’inférence d’IA se produit lorsque les utilisateurs interagissent directement avec un modèle ML intégré dans une application. Par exemple, lorsque l’utilisateur saisit une requête dans ChatGPT et reçoit une réponse, le temps pendant lequel ChatGPT « réfléchit » correspond à l’inférence, et le résultat est le produit de cette inférence.

L’inférence d’IA à la périphérie est un sous-ensemble de l’inférence d’IA, où un modèle ML fonctionne sur un serveur proche des utilisateurs finaux, par exemple, dans la même région ou même la même ville. Cette proximité réduit la latence à quelques millisecondes, ce qui est bénéfique pour des applications en temps réel telles que la reconnaissance d’images, la détection de fraudes ou la génération de cartes de jeux.

Relation entre l’inférence d’IA à la périphérie et l’Edge AI

L’inférence d’IA à la périphérie fait partie de l’Edge AI. L’Edge AI implique le traitement des données et l’exécution de modèles ML à proximité de la source de données plutôt que dans le cloud. Cela englobe tout ce qui concerne le calcul à la périphérie, des serveurs de périphérie (métro edge) aux dispositifs IoT et aux stations de base de télécommunications (far edge). L’Edge AI inclut également l’entraînement à la périphérie, pas seulement l’inférence. Cet article se concentrera sur l’inférence d’IA sur les serveurs de périphérie.

Comparaison entre l’inférence à la périphérie et l’inférence dans le cloud

Avec l’inférence d’IA dans le cloud, un modèle ML est exécuté sur un serveur distant, et les données des utilisateurs sont envoyées et traitées dans le cloud. Dans ce cas, un utilisateur peut interagir avec le modèle depuis une région, un pays ou même un continent différent. Par conséquent, la latence de l’inférence cloud peut varier de plusieurs centaines de millisecondes à quelques secondes. Ce type d’inférence d’IA convient aux applications qui ne nécessitent pas de traitement local des données ou une faible latence, comme ChatGPT, DALL-E et d’autres outils GenAI populaires. L’inférence à la périphérie se distingue de deux manières :

- L’inférence se produit plus près de l’utilisateur final

- La latence est réduite

Fonctionnement de l’inférence d’IA à la périphérie

L’inférence d’IA à la périphérie repose sur une infrastructure informatique dotée de deux composants architecturaux principaux : un réseau à faible latence et des serveurs équipés de puces d’IA. Pour une inférence d’IA évolutive capable de gérer des pics de charge, un service d’orchestration de conteneurs, tel que Kubernetes, est également nécessaire ; cela fonctionne sur des serveurs de périphérie et permet à vos modèles ML de s’adapter rapidement et automatiquement. Actuellement, seuls quelques fournisseurs disposent de l’infrastructure nécessaire pour offrir une inférence d’IA à la périphérie à l’échelle mondiale répondant à ces exigences.

Réseau à faible latence : Un fournisseur d’inférence d’IA à la périphérie doit disposer d’un réseau distribué de points de présence (PoPs) où les serveurs sont situés. Plus il y a de PoPs à la périphérie, plus le temps de réponse du réseau est rapide, ce qui signifie que les réponses des modèles ML sont plus rapides pour les utilisateurs finaux. Un fournisseur devrait avoir des dizaines, voire des centaines, de PoPs dans le monde et offrir un routage intelligent, qui dirige une demande utilisateur vers le serveur de périphérie le plus proche pour utiliser efficacement le réseau distribué mondialement.

Serveurs avec accélérateurs d’IA : Pour réduire le temps de calcul, il est nécessaire d’exécuter votre modèle ML sur un serveur ou une VM alimentée par un accélérateur d’IA, tel que le GPU NVIDIA. Il existe des GPU spécifiquement conçus pour l’inférence d’IA. Par exemple, l’un des derniers modèles, le NVIDIA L40S, offre des performances d’inférence jusqu’à 5 fois plus rapides que les GPU A100 et H100, qui sont principalement conçus pour l’entraînement de grands modèles ML mais sont également utilisés pour l’inférence. Le GPU NVIDIA L40S est actuellement le meilleur accélérateur d’IA pour réaliser des inférences d’IA.

Orchestration de conteneurs : Le déploiement de modèles ML dans des conteneurs rend les modèles évolutifs et portables. Un fournisseur peut gérer un outil d’orchestration de conteneurs sous votre responsabilité. Dans ce cadre, un ingénieur ML cherchant à intégrer un modèle dans une application n’aurait qu’à télécharger une image de conteneur avec un modèle ML et obtenir un point de terminaison de modèle ML prêt à l’emploi. Lorsqu’un pic de charge se produit, les conteneurs avec votre modèle ML s’adapteront automatiquement, puis se réduiront lorsque la charge diminuera.

Avantages clés de l’inférence d’IA à la périphérie

L’inférence d’IA à la périphérie présente trois avantages majeurs dans divers secteurs ou cas d’utilisation : faible latence, sécurité et souveraineté, et efficacité des coûts.

Faible latence

Plus la latence du réseau est faible, plus votre modèle répondra rapidement. Si la latence moyenne d’un fournisseur est inférieure à 50 ms, cela convient à la plupart des applications nécessitant une réponse quasi instantanée. En comparaison, la latence dans le cloud peut atteindre plusieurs centaines de millisecondes, selon votre emplacement par rapport au serveur cloud. Cela représente une différence significative pour un utilisateur final, la latence cloud pouvant entraîner de la frustration alors que les utilisateurs attendent leurs réponses d’IA.

Il est important de noter qu’un réseau à faible latence ne prend en compte que le temps de trajet des données. Une latence réseau de 50 ms ne signifie pas que les utilisateurs recevront une sortie d’IA en 50 ms ; il faut ajouter le temps que le modèle ML met à effectuer l’inférence. Ce temps de traitement du modèle ML dépend du modèle utilisé et peut représenter la majorité du temps de traitement pour les utilisateurs finaux. C’est d’autant plus une raison de s’assurer que vous utilisez un réseau à faible latence, afin que vos utilisateurs obtiennent le meilleur temps de réponse possible pendant que les développeurs de modèles ML continuent d’améliorer la vitesse d’inférence des modèles.

Sécurité et souveraineté

Conserver les données à la périphérie, c’est-à-dire localement pour l’utilisateur, simplifie la conformité avec les lois et réglementations locales, telles que le RGPD et ses équivalents dans d’autres pays. Un fournisseur d’inférence à la périphérie doit configurer son infrastructure d’inférence pour respecter les lois locales afin de garantir que vous et vos utilisateurs êtes protégés de manière appropriée.

L’inférence à la périphérie augmente également la confidentialité et la sécurité des données de vos utilisateurs finaux, car elles sont traitées localement plutôt que d’être envoyées vers des serveurs cloud distants. Cela réduit la surface d’attaque et minimise le risque d’exposition des données lors de la transmission.

Efficacité des coûts

En général, un fournisseur ne facture que les ressources informatiques utilisées par le modèle ML. Cela, associé à une autoscaling soigneusement configurée et à des horaires d’exécution de modèles, peut réduire considérablement les coûts d’inférence. Qui devrait utiliser l’inférence d’IA à la périphérie ?

Voici quelques scénarios courants où l’inférence à la périphérie serait le choix optimal :

- La faible latence est cruciale pour votre application et vos utilisateurs. Une large gamme d’applications en temps réel, de la reconnaissance faciale à l’analyse commerciale, nécessite une faible latence. L’inférence à la périphérie offre l’option d’inférence avec la latence la plus basse.

- Votre base d’utilisateurs est répartie sur plusieurs emplacements géographiques. Dans ce cas, vous devez offrir la même expérience utilisateur, c’est-à-dire la même faible latence, à tous vos utilisateurs, quel que soit leur emplacement. Cela nécessite un réseau de périphérie distribué à l’échelle mondiale.

- Vous ne souhaitez pas vous occuper de la maintenance de l’infrastructure. Si le soutien à l’infrastructure cloud et IA ne fait pas partie de votre cœur de métier, il peut être judicieux de déléguer ces processus à un partenaire expérimenté. Vous pourrez ainsi concentrer vos ressources sur le développement de votre application.

- Vous souhaitez garder vos données localement, par exemple, dans le pays où elles sont générées. Dans ce cas, vous devez effectuer l’inférence d’IA aussi près que possible de vos utilisateurs finaux. Un réseau de périphérie distribué à l’échelle mondiale peut répondre à ce besoin, tandis que le cloud est peu susceptible d’offrir l’étendue de distribution requise.

Secteurs bénéficiant de l’inférence d’IA à la périphérie

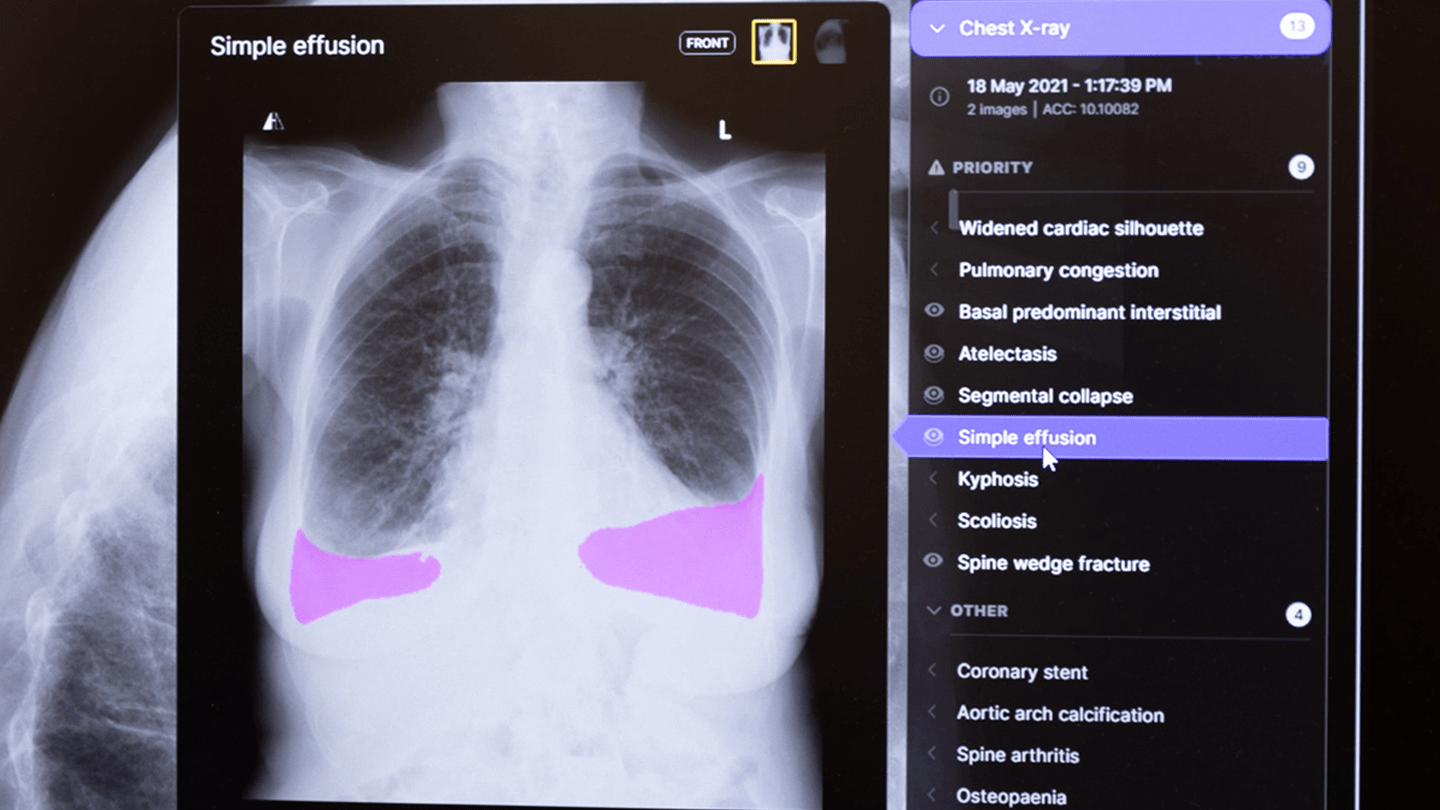

L’inférence d’IA à la périphérie profite à tous les secteurs où l’IA/ML est utilisée, mais surtout à ceux développant des applications en temps réel. Dans le secteur technologique, cela inclut les applications d’IA générative, les chatbots et assistants virtuels, l’augmentation de données et les outils d’IA pour les ingénieurs logiciels. Dans le domaine du jeu, cela concerne la génération de contenu et de cartes d’IA, l’analyse des joueurs en temps réel et la personnalisation des bots d’IA et des conversations. Pour le marché de la vente au détail, les applications typiques incluent les courses intelligentes avec auto-enregistrement, l’essayage virtuel, ainsi que la génération de contenu, les prédictions et les recommandations.

Dans le secteur manufacturier, les avantages se manifestent par la détection en temps réel des défauts dans les chaînes de production, les applications VR/VX et les retours d’informations rapides, tandis que dans l’industrie des médias et du divertissement, cela concerne l’analyse de contenu, la traduction en temps réel et la transcription automatisée. Un autre secteur développant des applications en temps réel est l’automobile, notamment pour les réponses rapides des véhicules autonomes, la personnalisation des véhicules, l’assistance avancée au conducteur et les mises à jour de trafic en temps réel.

Conclusion

Pour les organisations cherchant à déployer des applications en temps réel, l’inférence d’IA à la périphérie est un élément essentiel de leur infrastructure. Elle réduit considérablement la latence, garantissant des temps de réponse ultra-rapides. Pour les utilisateurs finaux, cela signifie une expérience plus fluide et engageante, que ce soit en jouant à des jeux en ligne, en utilisant des chatbots ou en faisant des achats en ligne avec un service d’essayage virtuel. Une sécurité des données renforcée permet aux entreprises d’offrir des services d’IA supérieurs tout en protégeant les données des utilisateurs. L’inférence d’IA à la périphérie est un catalyseur essentiel pour le déploiement à grande échelle de l’IA/ML, favorisant l’innovation et l’efficacité dans de nombreux secteurs.